4 czy 5 przemysłowych rewolucji?

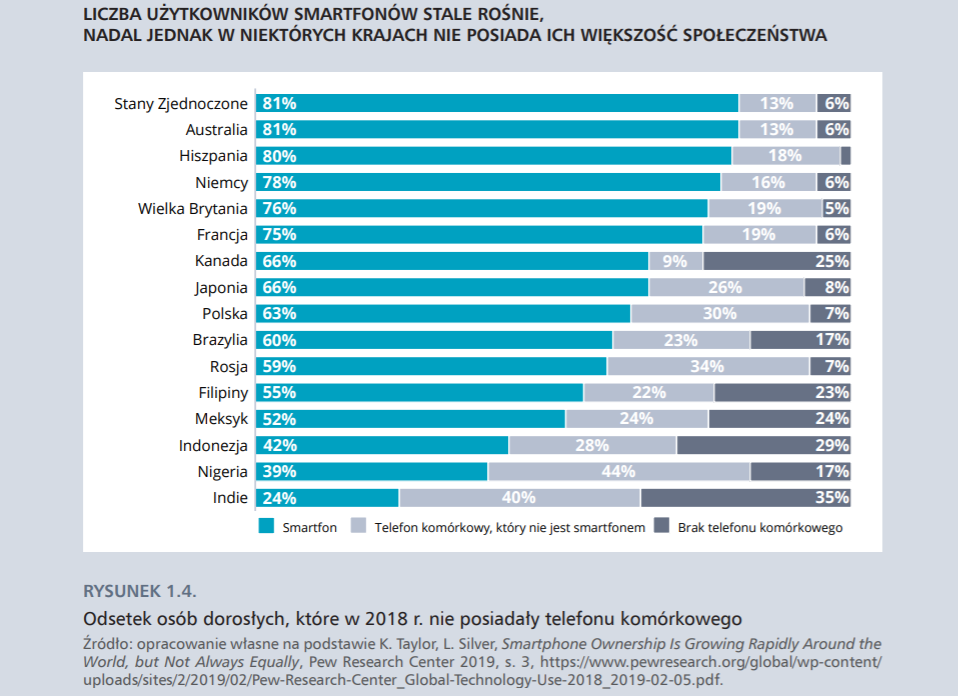

W 2018 r. ponad pięć miliardów ludzi – 2/3 światowej populacji – miało telefon działający na zasadzie łączności bezprzewodowej. Co trzecie z tych urządzeń to smartfon – telefon będący jednocześnie przenośnym komputerem, którego moc obliczeniowa tysiąckrotnie przekracza moc komputera, który w 1969 r. pomagał wysłać ludzi na Księżyc. Dzięki podłączeniu do globalnej sieci internetowej na wyciągnięcie ręki – a raczej na skinięcie palcem – mamy dostęp do archiwum wiedzy zgromadzonej przez ludzkość, znajomych w portalu społecznościowym oraz cyfrowych usług oferowanych przez platformy internetowe. Sztuczna inteligencja wykorzystująca sieci neuronowe nauczyła się wygrywać w pokera – grę wymagającą nie tylko umiejętności myślenia dedukcyjnego, ale i intuicji, uważanej za przymiot czysto ludzki. Zachodząca na naszych oczach czwarta rewolucja technologiczna opiera się na wynalazkach, o jakich nie śniło się filozofom, ale o których marzyli twórcy science fiction. Ci z nas, którzy wyrośli w świecie bez internetu, smartfonów i sztucznej inteligencji, doświadczają „szoku przyszłości” głębszego, niż przewidzieli twórcy tego terminu, socjologowie Alvin i Heidi Toefflerowie, w latach 70. XX wieku.

Dlaczego właśnie czwarta? Numeracja kolejnych rewolucji technologicznych – czyli gwałtownych zmian gospodarczych, społecznych i politycznych związanych z upowszechnieniem się nowej technologii – ma charakter umowny. Podział, zaproponowany w latach 70. XX w. przez amerykańskiego socjologa Daniela Bella, zakładał, że pierwszą wywołało wynalezienie maszyny parowej, druga nastała wraz z wynalezieniem elektryczności, a trzecia – zachodzi w wyniku automatyzacji i komputeryzacji. Carlota Perez, badająca zjawisko innowacji, w książce „Technological Revolution and Financial Capital” (2002) pisze o pięciu rewolucjach. Pierwsza to rewolucja przemysłowa: jej umowny początek przypada na rok 1771, gdy Richard Arkwright, wynalazca udoskonalonego krosna, otwiera swoją pierwszą fabrykę w Wielkiej Brytanii. Druga wiąże się z upowszechnieniem silnika parowego i rozpoczyna ją test lokomotywy zwanej Rakietą w 1829 r. Trzecią rewolucję – stali i elektryfikacji przemysłu ciężkiego – symbolizuje otwarcie fabryki stali Carnegie Bessemer w 1875 r. Emblematami kolejnej rewolucji – czwartej – staną się ropa naftowa, samochód i produkcja masowa. Rozpoczyna się ona w 1908 r., gdy z linii produkcyjnej Forda zjeżdża pierwszy model T, a kończy wraz z nastaniem epoki informacji i telekomunikacji. To piąta rewolucja, która została zainicjowana pojawieniem się w 1971 r. mikroprocesora firmy Intel. Podejście Perez – wyodrębniające dwa etapy pierwszej rewolucji przemysłowej: mechaniczny i parowy – nie zyskało jednak popularności.

W dyskursie naukowym i biznesowym dominuje przekonanie, że obecnie mamy do czynienia z czwartą rewolucją technologiczną (a także przemysłową, społeczną i polityczną). Takie podejście prezentuje założyciel organizacji World Economic Forum, Klaus Schwab, w książce „The Fourth Industrial Revolution” (2016). Dwaj dziennikarze, John Mickletwaite i Adrian Wooldridge, piszą o czwartej rewolucji w kontekście przejścia do „inteligentnego państwa” („smart state”), wykorzystującego nowe technologie. Tego samego terminu używa także Luciano Floridi w książce „The Fourth Revolution. How the Infosphere is Reshaping Human Reality” (2014). Floridi pisze o przemianach w sposobie, w jaki człowiek rozumie samego siebie. Pierwsza rewolucja – kopernikańska, obaliła przekonanie, że ludzkość jest centrum kosmosu; druga – darwinowska, dowiodła, że człowiek nie jest królem stworzenia; trzecia rewolucja – freudowska, obaliła założenie o racjonalności ludzkiego umysłu. Czwarta rewolucja bierze nazwę od genialnego matematyka, który stworzył podwaliny dla rozwoju technologii informatycznych – Alana Turinga. W wyniku rewolucji turingowskiej i pojawienia się sztucznej inteligencji człowiek traci wyjątkową pozycję jedynej istoty zdolnej do logicznego myślenia, przetwarzania informacji i inteligentnego zachowania. Nasycenie rzeczywistości nowymi technologiami sprawia, że ludzie zmieniają się w organizmy informacyjne (inforgi), zanurzone w infosferze, w której funkcjonują inne podmioty informacyjne, również te „nie-ludzkie”. Pisząc o czwartej rewolucji technologicznej, podążałyśmy za wymienionymi wyżej autorami.

Innowacja kombinatoryjna

Najbardziej wyrazistą cechą czwartej rewolucji technologicznej jest rosnące natężenie innowacji kombinatoryjnej. Klasyczne podejście do zmiany technologicznej, zaproponowane na początku XX w. przez austriackiego ekonomistę Josepha Schumpetera, zakładało, że jej pierwszym etapem jest wynalazek: nowy produkt lub proces. Wynalazek ma charakter naukowo-techniczny, może nigdy nie wykroczyć poza ściany laboratorium czy garażu wynalazcy. Innowacja to już fakt ekonomiczny, wywierający wpływ na gospodarkę, chociaż może mieć niszowy charakter. Dopiero dyfuzja, czyli upowszechnienie, przekształca innowację w fenomen socjoekonomiczny. Nowsze ujęcie, rozwijane m.in. przez stanfordzkiego ekonomistę W. Briana Arthura w książce „The Nature of Technology” (2011), zakłada, że technologia nie powstaje w sposób linearny, lecz że technologie składają się z technologii, powstają jako kombinacje innych technologii. Mechanizm ten cechował również poprzednie rewolucje technologiczne, ale przebiegał znacznie wolniej, m.in. ze względu na tempo obiegu wiedzy. Dyfuzja internetu, szczytowego wynalazku trzeciej rewolucji technologicznej, przyspieszyła i bezprecedensowo rozszerzyła obieg i wymianę wiedzy między badaczami i ośrodkami z całego świata. W dodatku, jak zauważa Hal Varian, główny ekonomista Google’a, przyspieszenie wynika również z dematerializacji głównego „substratu” działań innowacyjnych, czyli danych:

Wkroczyliśmy w etap, w którym mamy do dyspozycji składowe internetu: software, protokoły, języki – i możliwości łączenia tego wszystkiego tak, by powstawały kolejne innowacje. Najwspanialsze zaś jest to, że wszystkie elementy to bity. To oznacza, że nigdy ich nam nie zabraknie. Możemy je przetwarzać, powielać, rozsyłać po całym świecie, a dziesiątki tysięcy innowatorów może dzięki nim wykombinować i zrekombinować kolejne innowacje. Tutaj nie ma niedoborów. Nie ma opóźnień w dostawach. To sytuacja, w której komponenty są dostępne dla każdego, stąd bierze się niesamowity rozkwit innowacji, który widzimy wszędzie wokół.

Mechanizmy innowacji kombinatoryjnej niekiedy opierają się na przechwytywaniu innowacji stworzonej przez konkurencję, czego przykładem jest wojna patentowa, która toczyła się między Microsoftem a Google’em. W 2010 r. Microsoft uznał – trwa dyskusja, czy zasadnie – że system Android wykorzystuje rozwiązania stanowiące jego własność intelektualną. Firma zaczęła pobierać wysokie opłaty za licencje na Androida, co skłoniło producentów urządzeń do szukania innych rozwiązań systemowych, takich jak Windows Phone czy Firefox OS. W 2015 r. ogłoszono zakończenie sporu i rozejm między Google’em i Microsoftem, nie zdradzając szczegółów ugody. Poinformowano jedynie o podjęciu współpracy między firmami, dotyczącej patentów oraz opracowania nowych technologii sieciowych. Zdaniem Kai Fu Lee, autora książki „AI Superpowers” (2018), nadmierne poszanowanie dla zasady własności intelektualnej w coraz większym stopniu ogranicza innowacyjność działań podejmowanych w ekosystemie firm technologicznych w amerykańskiej Dolinie Krzemowej. Startupy funkcjonujące w chińskim ekosystemie nie mają takich hamulców – umiejętność szybkiego kopiowania konkurencyjnych rozwiązań i ich ulepszania jest tam uważana za przejaw przedsiębiorczości, co w ostatecznym rozrachunku może przesądzić o ich globalnym sukcesie.

W artykule przedstawiamy zwięzłą historię ewolucji nowych technologii, warunkujących powstawanie gospodarki cyfrowej. Naszym celem jest nakreślenie kontekstu transformacji cyfrowej, dlatego nie wchodzimy w szczegóły techniczne, a skupiamy się na najważniejszych mechanizmach. Najpierw wyjaśnimy znaczenie technologii założycielskich czwartej rewolucji technologicznej, do których zaliczamy komputer, internet i smartfon.

Komputer

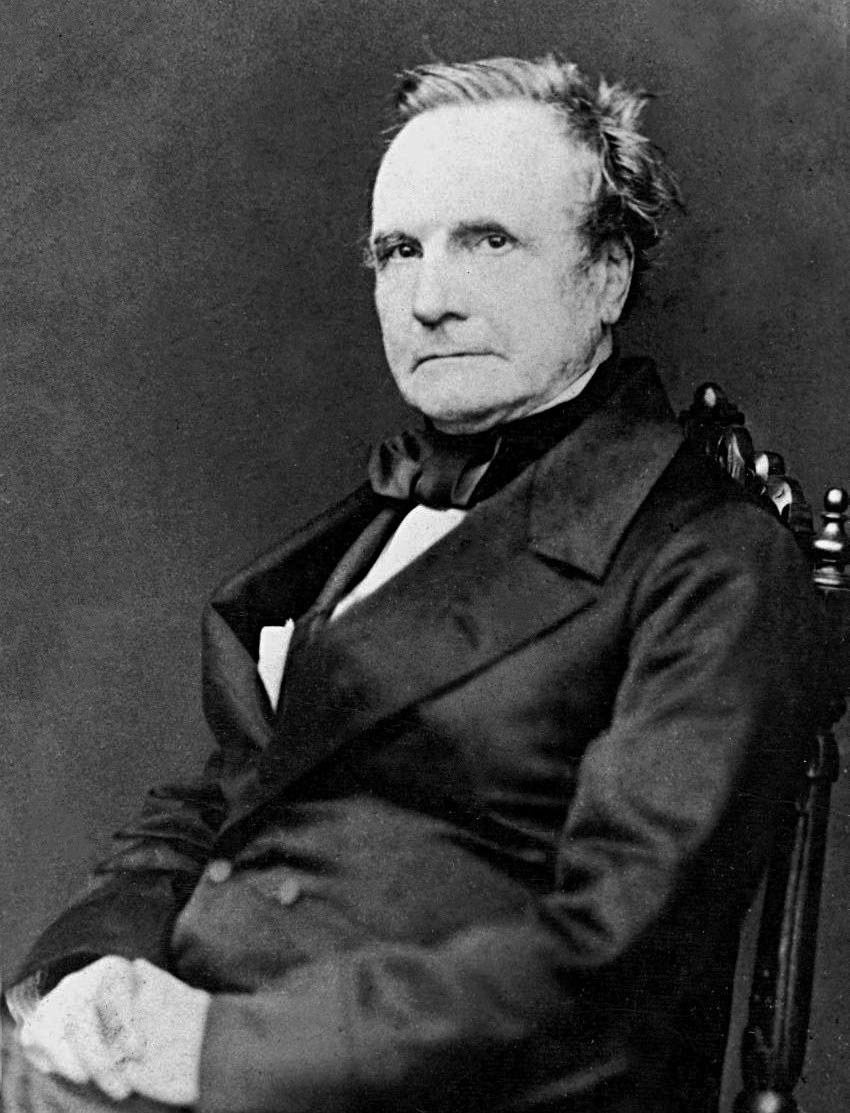

Epokową innowacją, która zapoczątkowała trzecią rewolucję technologiczną, był komputer. Sam pomysł stworzenia programowalnej maszyny obliczeniowej (analytical engine) jest przypisywany angielskiemu matematykowi Charlesowi Babbage’owi. W 1834 r. Babbage przedstawił projekt maszyny parowej, która mogłaby wykonywać mozolną i czasochłonną pracę „kalkulatorów”, czyli ludzi zajmujących się ręcznymi obliczeniami. Maszyna miała być zbudowana z pamięci (store), magazynującej dane, o pojemności 675 bitów, oraz młyna (mill), wykonującego obliczenia. Można ją było programować przy użyciu dziurkowanych kart, podobnych do tych używanych w maszynach żakardowych. Pierwsze programy, które mogłyby działać na maszynie Babbage’a, napisała matematyczka Ada Lovelace.

Babbage nigdy nie zdołał jednak zbudować swojej napędzanej parą maszyny: była zbyt skomplikowana, zbyt wielka (rozmiar małej lokomotywy) i zbyt kosztowna. Praktyczne problemy konstrukcyjne niemal pokonały nawet entuzjastów z londyńskiego Muzeum Nauki zaangażowanych w projekt jej rekonstrukcji. Pierwsze komputery, które powstały ponad sto lat później, działały jednak na podobnej zasadzie: miały wydzielony moduł pamięci i moduł analityczny, można było je programować przy użyciu przełączników i wtyczek. Ich konstrukcja była jednak prostsza dzięki innej epokowej innowacji – elektryfikacji. Nadal jednak zajmowały bardzo dużo miejsca: stworzone w latach 1943–1945 brytyjskie programowalne maszyny elektroniczne, wykorzystywane do rozszyfrowywania niemieckich komunikatów wojskowych, zasadnie były nazywane Colossusami, w Stanach Zjednoczonych pierwsze komputery nazywano czule „wielkim żelastwem” („Big Iron”). Pierwszy komputer przeznaczony do celów komercyjnych – Ferranti Mark 1 z 1951 r. – ważył pół tony, a jego obsługa wymagała zaawansowanych umiejętności. Rosnące zainteresowanie komputerami ze strony przemysłu przełożyło się na zmianę ich funkcji: w coraz większym stopniu polegały one na przetwarzaniu danych, a nie wykonywaniu jedynie prostych operacji matematycznych.

Elektroniczne komputery znalazły przede wszystkim zastosowanie w rutynowych procesach administracyjnych – sporządzaniu list wypłat, zestawień rachunków i sporządzania raportów. Wszystkie te zadania były już przynajmniej częściowo zmechanizowane za pomocą maszyn do pisania, maszyn tabulacyjnych i kalkulatorów mechanicznych. W wielu dużych korporacjach zadania zostały oddelegowane do specjalnych departamentów przetwarzania danych. I to dla nich IBM pod koniec lat 50. projektował wiele komputerów, reklamując je jako narzędzia do „elektronicznego przetwarzania danych”. W latach 60. komputery w korporacjach były w większości wykorzystywane właśnie w tym celu, choć eksperci komputerowi postrzegali to zastosowanie technologii komputerowej jako najmniej interesujące.

(M. Campbell-Kelly i in., Computer: A History of the Information Machine.)

Do zmniejszenia rozmiaru komputerów przyczynił się kolejny wynalazek – tranzystor (1948), który zastąpił nieefektywne lampy próżniowe wykorzystywane do wykonywania obliczeń. Dekadę później pojawił się układ scalony integrujący wszystkie elektryczne elementy komputera (tranzystory, przewodniki, oporniki, diody) w jednym krzemowym chipie. Nadal jednak każda funkcja komputera była obsługiwana przez oddzielny chip. Prawdziwy przełom nastąpił wraz z wynalezieniem mikroprocesora (pojedynczego układu scalonego o wielkim stopniu integracji).

Pierwszy mikroprocesor został wyprodukowany przez firmę Intel w 1971 r. dla producenta kalkulatorów Busicom. Tak powstał Intel 4004 – pierwszy mikroprocesor o ogólnym zastosowaniu. Klient wycofał się jednak z umowy i Intel został zmuszony do znalezienia innego rynku zbytu. Niemniej nie był jedynym podmiotem wdrażającym tę innowację. Równolegle technologię produkcji mikroprocesorów rozwijała pracująca dla wojska firma Garret oraz Texas Instruments, która zamierzała je stosować w produkowanych przez siebie kalkulatorach i to właśnie ona jako pierwsza zgłosiła patent. Ostatecznie spór zakończył się ugodą z Intelem.

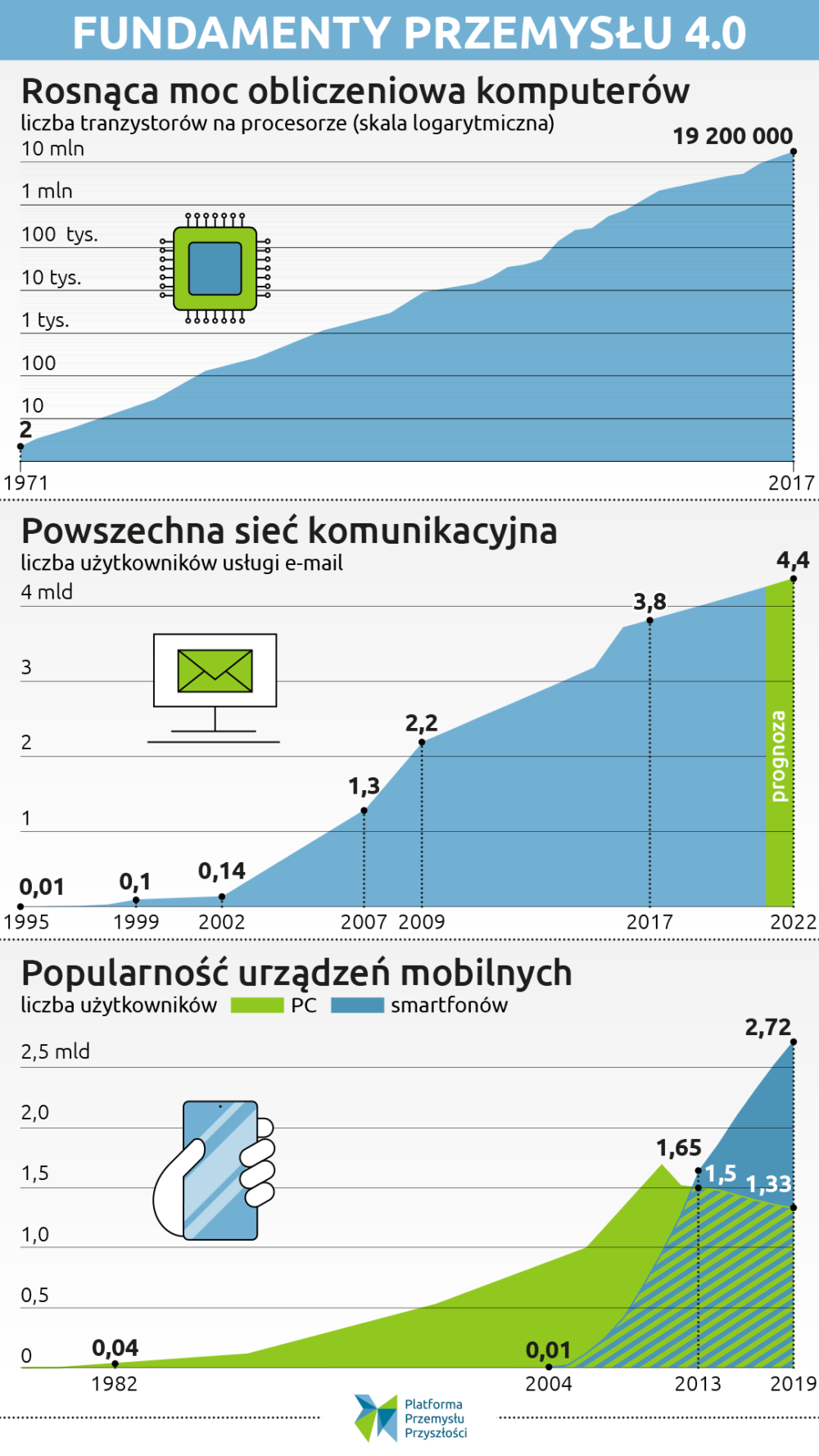

Pierwszy mikroprocesor Intela był wielkości 12 mm2, składał się z 2300 tranzystorów i wykonywał 60 tys. operacji na sekundę, ten wyprodukowany rok później miał już 3500 tranzystorów i wykonywał 300 tys. operacji na sekundę. Zgrubnie potwierdzało to zaproponowaną w 1965 r. tezę jednego z założycieli Intela, George’a Moore’a, dotyczącą regularnego podwajania się liczby tranzystorów umieszczonych na mikroprocesorze.

Prawo Moore’a pierwotnie zakładało, że liczba umieszczonych na mikroprocesorze tranzystorów będzie się podwajała co półtora roku. Dekadę później Moore zmodyfikował swoje twierdzenie: liczba mikroprocesorów miała się odtąd podwajać co dwa lata. Chociaż prawo Moore’a było raczej prawidłowością sformułowaną na podstawie obserwacji, przez lata zachowywało zadziwiającą trafność. Dopiero w ostatnich latach tempo miniaturyzacji zaczęło wyhamowywać. Zmniejszanie się wielkości urządzeń mechanicznych, optycznych i elektronicznych doprowadziło do utworzenia tranzystorów o rozmiarach bliskich atomom. Według raportu Semiconductor Industry Association z 2015 r., zbliżamy się do fizycznej granicy wielkości mikroprocesora. Jej osiągnięcie nie kończy jednakże kariery prawa Moore’a, które dotyczyło jedynie okresowego podwajania się liczby tranzystorów na równej powierzchni, a współcześnie stawia się na struktury trójwymiarowe. Możliwe jednak, że granica kilku nanometrów jest tylko kolejną tymczasową barierą, która zostanie pokonana za sprawą komputerów kwantowych.

Miniaturyzacja sprawiła, że komputery stały się mniejsze i tańsze. Pojawienie się procesora Intel 8008 przyczyniło się do powstania pierwszych mikrokomputerów (np. francuskiego Miracle), co w latach 70. zaowocowało fenomenem komputerów osobistych (personal computers, pecety, komputery biurkowe). W 1977 r. firma Apple Computers, założona przez Steve’a Jobsa i Steve’a Wozniaka, zaczęła sprzedawać model Apple II, który szybko zagościł nie tylko w biurach, ale i w domach Amerykanów. W odróżnieniu od wcześniej sprzedawanych komputerów domowych, Apple II miał kolorowy wyświetlacz, klawiaturę i imponujące jak na tamte czasy 48 KB pamięci RAM. Z kolei w 1981 r. na rynek wszedł pierwszy przenośny komputer Osborne 1 – wprawdzie nie miał baterii, ale ważył ok. 10 kg, więc można go było względnie swobodnie przenosić z miejsca na miejsce. Pierwsze komputery, które naprawdę można było trzymać na kolanach, pojawiły się pod koniec lat 80. Należał do nich np. Compaq LTE, za którego sprawą – jak pisała ówczesna prasa – posługiwanie się komputerem w podróży stało się równie łatwe jak w biurze” (co ciekawe, ten kiedyś najlżejszy laptop jest nadal używany do serwisowania niegdyś najszybszego auta na świecie – McLarena F1). Kolejnym punktem zwrotnym w rozwoju komputerów osobistych okazał się pierwszy PowerBook, wypuszczony na rynek przez Apple w 1991 r. Model wyznaczył nowy standard projektowania laptopów.

Liczba komputerów rosła w nierównomiernym, ale niepowstrzymanym tempie. W 1955 r. na świecie było tylko 250 komputerów, dekadę później – 20 tys. Używało ich wojsko, uniwersytety i instytucje publiczne. W 1977 r. sprzedano 48 tys. komputerów osobistych, w 2001 r. – 125 mln. Łącznie między 1970 a 2014 r. sprzedano ok. 1 mld komputerów osobistych. W krajach wysoko rozwiniętych komputer jest w niemal każdym gospodarstwie domowym.

Co ważne, komputery były kupowane nie tylko przez firmy i urzędy, ale i gospodarstwa domowe. Przyczyną stał się nie tylko mniejszy rozmiar i bardziej przystępna cena, ale przede wszystkim większa użyteczność, jaką zapewniał rozwój oprogramowania (software) oraz coraz bardziej przyjazne interfejsy użytkownika (np. myszka). Pierwsze komputery na użytek własny kupowali raczej zapaleni hobbyści: popularny w połowie lat 70. komputer-składak Altair nie miał klawiatury ani ekranu, obsługiwany był za pomocą przełączników, a rezultaty jego obliczeń pojawiały się pod postacią zapalających się lampek. Łatwiejszy w obsłudze okazał się dopiero wtedy, gdy produkująca go firma zatrudniła dwóch studentów Harvardu – Paula Allena i Billa Gatesa, by dostosowali do jego potrzeb jeden z języków programowania. Zarobione w ten sposób pieniądze Gates i Allen wykorzystali do założenia własnej firmy, którą nazwali Micro-Soft (taka była postać jej pierwszej, historycznej nazwy). W 1981 r. ich firma przedstawiła system operacyjny MS-DOS, który błyskawicznie zdobył popularność i stał się bazą dla późniejszego systemu Windows. Równolegle Jobs i Wozniak zachęcili programistów do tworzenia aplikacji na Apple – jedną z najbardziej użytecznych okazał się arkusz kalkulacyjny VisiCalc, opracowany w 1978 r. Niemałą atrakcją komputerów domowych okazały się gry, ale prawdziwy wybuch popularności tych urządzeń nastąpił dopiero z rozwojem internetu.

Internet

W zasadzie internet został wymyślony na początku lat 60. XX w. przez wizjonerskiego psychologa i informatyka z MIT, Josepha C.R. Licklidera. W artykule „On-line man-computer communication” z 1962 r. Lick, jak nazywali go wielbiciele, opisał zasady funkcjonowania rozbudowanej sieci komputerów wymieniających się danymi i programami, o globalnym zasięgu, umożliwiającej komunikację na odległość. Był właściwym człowiekiem na właściwym miejscu – pracował już wówczas w podległej Pentagonowi Agencji Badań Zaawansowanych (Advanced Research Projects Agency, czyli ARPA), a jego pomysły niosły obietnicę rozwiązania problemu spędzającego wojskowym sen z powiek. Systemy obrony były zbudowane promieniście wokół jednego głównego komputera. Jego likwidacja – np. w wyniku wyprzedzającego uderzenia atomowego ze strony ZSRR (a przypomnijmy, że jesienią 1962 r. w trakcie kryzysu kubańskiego świat przez 13 dni balansował na granicy konfliktu nuklearnego) – unicestwiała cały system. Rozwiązaniem było stworzenie sieci równolegle podłączonych urządzeń, komunikujących się na zasadzie komutacji pakietów (packet switching), czyli dzielenia strumienia danych na mniejsze części i następnie przesyłania ich za pośrednictwem łączy telekomunikacyjnych między węzłami sieci.

Niektórzy twierdzą, że wojskowa geneza powstania internetu to tylko mit, a jego rozwój wynikał po prostu z faktu, że naukowcy pracujący na potężnych niemobilnych komputerach potrzebowali jakiegoś sposobu na wymienianie się danymi. W 1969 r. naukowcy z Uniwersytetu Kalifornijskiego (The University of California, Los Angeles, UCLA) podjęli próbę zalogowania się na komputer znajdujący się na oddalonym o 600 km Uniwersytecie Stanforda i przesłania danych pod postacią jednego słowa „login”. Rozentuzjazmowani naukowcy komentowali przez telefon pojawianie się kolejnych liter na ekranie, ale po wpisaniu „G” system się zawiesił – przesłanie całego wyrazu udało się godzinę później. Wydarzenie to było początkiem internetowej rewolucji. Wkrótce do ARPANET-u (Advanced Research Projects Agency Network) podłączyły się również Uniwersytet Kalifornijski w Santa Barbara i Uniwersytet Utah. W latach 70. do projektu dołączały kolejne ośrodki akademickie, jednak rozwój sieci nadal toczył się pod ścisłym nadzorem Pentagonu.

Równolegle nad swoimi sieciami i rozwiązaniami technologicznymi pracowały jeszcze: brytyjski National Physics Laboratory (NPL network), Uniwersytet Hawajski (ALOHAnet), Michigan Educational Research Information Triad (Merit Network), francuskie CYCLADES, Tymnet i Telenet oraz inne. Każdy z nich używał innych protokołów sieciowych – dalsza ekspansja sieci wymagała powstania standardowego systemu przesyłu danych.

Umożliwienie, by komputery ze sobą rozmawiały, czyli połączenie ich w sieć – tzw. networking – było wystarczająco trudne. Ale doprowadzenie do sytuacji, w której rozmawiają ze sobą całe sieci, czyli internetworking, tworzyło zupełnie nowy poziom trudności, ponieważ sieci mówiły obcymi, niekompatybilnymi dialektami. Próba przesłania danych z jednej do drugiej przypominała pisanie listu po chińsku do kogoś, kto zna tylko węgierski, licząc, że jakimś cudem uda się dogadać.

(B. Tarnoff, How the internet was invented, The Guardian.)

Rozwiązaniem stał się model o warstwowej strukturze o nazwie TCP (Transmission Control Program) opracowany w 1973 r. przez Roberta Kahna z ARPANET-u i Vintona Cerfa ze Stanford University. Zapewniał on niezależność od platformy oraz możliwość dodawania nowych sieci bez przerywania pracy istniejących. W ciągu dekady TCP/IP (dodane zostało Internet Protocol jako warstwa bezpołączeniowa, a słowo Program zamieniono na Protocol) zastąpił wszystkie wcześniejsze protokoły w ARPANET.

W 1981 r. amerykańska Narodowa Fundacja na Rzecz Nauki wsparła rozwój sieci obejmującej regionalne kampusy uniwersyteckie, połączonej z ARPANET-em, która ostatecznie przekształciła się w NSFNET (National Science Foundation Network). NSFNET służyła jako szkielet dla sieci w USA do czasu pojawienia się prywatnych dostawców usług internetowych. Wtedy właśnie do powszechnego użycia weszło określenie „internet” jako skrót od terminu „internetworking”, opisującego współpracę między sieciami umożliwioną przez zastosowanie protokołu TCP/IP. Zainteresowanie siecią i jej możliwymi zastosowaniami rosło błyskawicznie. W połowie lat 80. własną sieć zbudowała NASA: łączyła ona 20 tys. naukowców z całego świata i stanowiła pierwszy prawdziwy przykład sieci rozległej (Wide Area Network, WAN). Między 1984 a 1988 r. Europejska Organizacja Badań Jądrowych (CERN) rozpoczęła wdrażanie protokołu TCP/IP do swojej sieci, CERNET. Równolegle sieci oparte na TCP/IP zaczęły rozwijać się w Australii i Azji. Pierwsza, trwająca minutę transmisja internetowa z Polski, połączyła Instytut Fizyki UW i Centrum Komputerowe na Uniwersytecie Kopenhaskim w 1990 r.

Pierwsze firmy oferujące dostawę usług internetowych (Internet Service Providers, ISP) zaczęły pojawiać się na początku lat 80., jednak wykorzystanie sieci na użytek komercyjny rozwinęło się dopiero po przegłosowaniu w 1991 r. w amerykańskim Kongresie ustawy zezwalającej sieci NSFNET na łączenie się z innymi sieciami komercyjnymi. Ostatnie ograniczenia rozwoju sieci zostały zniesione w 1995 r. Jak wspomina założyciel pierwszej brytyjskiej firmy dostarczającej usługi internetowe, Demon Internet, która w 1993 r. miała blisko 3000 klientów:

Ludzie ciągle pytali: „OK, jestem już podłączony, i co teraz?”. To było jedno z najczęściej zadawanych pytań na infolinii. Odpowiadaliśmy: „A co państwo chcecie zrobić? Może wysłać mejla?”. „Ale ja nie znam nikogo z adresem mejlowym”. Ludzie się podłączyli, ale nie wiedzieli, co dalej.

(O. Burkeman, Forty years of the internet: how the world changed for ever, The Guardian.)

Ci już podłączeni korzystali głównie z najstarszej aplikacji internetowej, czyli istniejącej od początku lat 70. poczty elektronicznej.

Pierwszego maila wysłał w 1971 r. Ray Tomlinson, członek projektu ARPANET. Ku rozpaczy historyków nowych technologii niestety nie zapamiętał jego treści i jest skłonny twierdzić, że był to po prostu zbitek liter typu „QWERTYUIOP”. To Tomlinson wybrał symbol @ w celu zidentyfikowania odbiorcy wiadomości. Rok później powstał pierwszy program do obsługi maili umożliwiający wybieranie, przesyłanie wiadomości oraz odpowiadanie na nie. W 1997 r. z maila korzystało ponad 10 mln użytkowników, w 2019 r. z poczty elektronicznej korzysta 3,8 mld ludzi.

Podstawowym problemem było wyszukiwanie informacji w sieci. Pod koniec lat 80. zaczęły powstawać programy archiwizujące: jednym z pierwszych był Archie, stworzony przez dwóch studentów McGill University w Montrealu, Alana Emtage’a i Petera Deutscha. Archie co jakiś czas przeszukiwał wszystkie dostępne strony ftp, tworzył listę zamieszczonych na nich plików, a następnie budował indeks. Jego obsługa była jednak dość skomplikowana. Znacznie łatwiejszy w użyciu był protokół wymyślony przez Tima Bernersa-Lee i innych pracowników Europejskiego Laboratorium Cząstek Elementarnych w 1989 r., który stał się bazą dla World Wide Web. Opierał się na trzech technologiach, które ułatwiały publikowanie, wyszukiwanie i konsumowanie informacji online: Uniform Resource Locator (URL), Hyper-Text Transfer Protocol (HTTP) oraz Hyper-Text Markup Language (HTML). Dokumenty i zasoby internetowe są identyfikowane przez URL i łączone hiperlinkami. Na pierwszej opublikowanej stronie internetowej (dostępna pod linkiem http://info.cern.ch/hypertext/WWW/TheProject.html) można było przeczytać, że W3 to rozległa inicjatywa pozyskiwania informacji hipermedialnych, mająca na celu stworzenie powszechnego dostępu do wielkiego uniwersum dokumentów.

W 1993 r. Berners-Lee udostępnił WWW w darmowej domenie publicznej – tym samym sieć stała się dostępna dla wszystkich. Nośnikiem sukcesu World Wide Web stała się graficzna przeglądarka, która znacząco ułatwiła i uatrakcyjniła proces wyszukiwania: w 1993 r. pojawiła się przeglądarka Mosaic, pierwsza, która zainteresowała nie-geeków, a dwa lata później na rynek weszła jeszcze bardziej intuicyjna przeglądarka Netscape (skądinąd obydwie stworzył ten sam człowiek, Marc Andreessen). Systematycznie rozrastała się zawartość internetu: w 1993 r. funkcjonowało zaledwie sto kilkadziesiąt stron internetowych, w 1998 r. było ich już około 180 mln. Potrzebny był jakiś system hierarchizowania treści interesujących konkretnego użytkownika – jeden z nich, oparty na systemie „rangowania” (Page Rank), zaproponowało dwóch studentów, Larry Page i Sergey Brin. Tak narodziła się wyszukiwarka Google, która obecnie zgodnie z deklaracjami jej właścicieli indeksuje setki miliardów stron internetowych.

W 1995 r. do internetu, potocznie utożsamianego z zasobem stron WWW (choć to zaledwie jedna aplikacja światowej sieci komputerowej, nawet jeśli najpopularniejsza), podłączonych było już 18 mln osób. Do innych istotnych aplikacji internetowych należały e-mail oraz sieć P2P (peer-to-peer) opierająca się na zdecentralizowanym modelu komunikacji. Każdy członek sieci P2P ma takie same uprawnienia i może zainicjować połączenie w celu wymiany plików zapisanych na dyskach twardych. Pierwotnie struktura internetu była bliska P2P, ale w wyniku szybkiego rozwoju osobiste komputery użytkowników sieci przestały zapewniać wystarczającą przepustowość danych i stabilność. Aktualnie sieć P2P służy do (często nielegalnej) wymiany plików między milionami użytkowników. Pierwsza wiadomość za pośrednictwem komunikatora (wysłana 6 stycznia 1993 r.) na komunikatorze AOL przez późniejszego wiceprezesa tej firmy do żony brzmiała: Nie bój się… to ja. Kocham Cię i tęsknię za Tobą. Adresatka odpowiedziała Wow… ale to jest fajne! (Wow… this is so cool!). Miliony użytkowników szybko podzieliły ten pogląd.

Funkcjonalność internetu zwiększały wciąż powstające aplikacje umożliwiające czatowanie, uczestnictwo w forach i kupowanie online, a to przyciągało kolejnych użytkowników i sprzyjało powstawaniu firm zajmujących się handlem elektronicznym. Jedną z pierwszych takich firm był Amazon, założony w 1995 r. W połowie pierwszej dekady XXI w. internet ewoluował ze zbioru statycznych stron internetowych (Web 1.0) w przestrzeń pełną dynamicznych treści współtworzonych przez jej użytkowników, takich jak blogi (Web 2.0). Proces ten nasiliło pojawienie się mediów społecznościowych, takich jak Facebook (2004) czy Twitter (2006).

Upowszechnianie się internetu było możliwe dzięki postępowi w obszarze kilku innych technologii. Kluczowym czynnikiem była rosnąca dostępność urządzeń, które można było do niego podłączyć, związana z postępem miniaturyzacji. Przełomową innowację mikroprocesora, który umożliwił produkcję komputerów biurkowych, uzupełniły innowacje w zakresie zmniejszania wielkości oraz poprawy wydajności baterii. Skutkowało to pojawieniem się laptopów, netbooków i tabletów oraz – w połączeniu z rozwojem nowych standardów w dziedzinie łączności – telefonów mobilnych.

Pierwszy telefon komórkowy w powszechnej sprzedaży – Motorola DynaTAC 8000x (1984) – ważył prawie kilogram (nawet jego konstruktorzy nazywali go „cegłą” – „The Brick”), kosztował ćwierć przeciętnej rocznej pensji, a na baterii działał tylko pół godziny. A jednak zrobił błyskawiczną karierę, zmiatając z rynku dotychczasowe „telefony mobilne”, czyli telefony samochodowe. Jak wspomina ówczesny szef marketingu sprzedającej ją firmy Ameritech:

Badania marketingowe pokazywały, że za taką cenę kupi go wąska grupa przedsiębiorców, lekarzy, agentów nieruchomości, właścicieli firm budowalnych i menadżerów dużych firm. Naszą grupą docelową nie byli nastolatkowie – no chyba że tacy, którzy mieli 4000 dolarów w kieszeni. Ale okazało się, że nie nadążamy z produkcją. Firmy zaczęły z nich korzystać i te urządzenia szybko stały się czymś innym, elementem biznesu, kwestią nie tyle wygody, ile konieczności. Nie spodziewaliśmy się takiej sprzedaży.

S. Wolpin, The First Cellphone Went on Sale 30 Years Ago for $4,000, (Mashable).

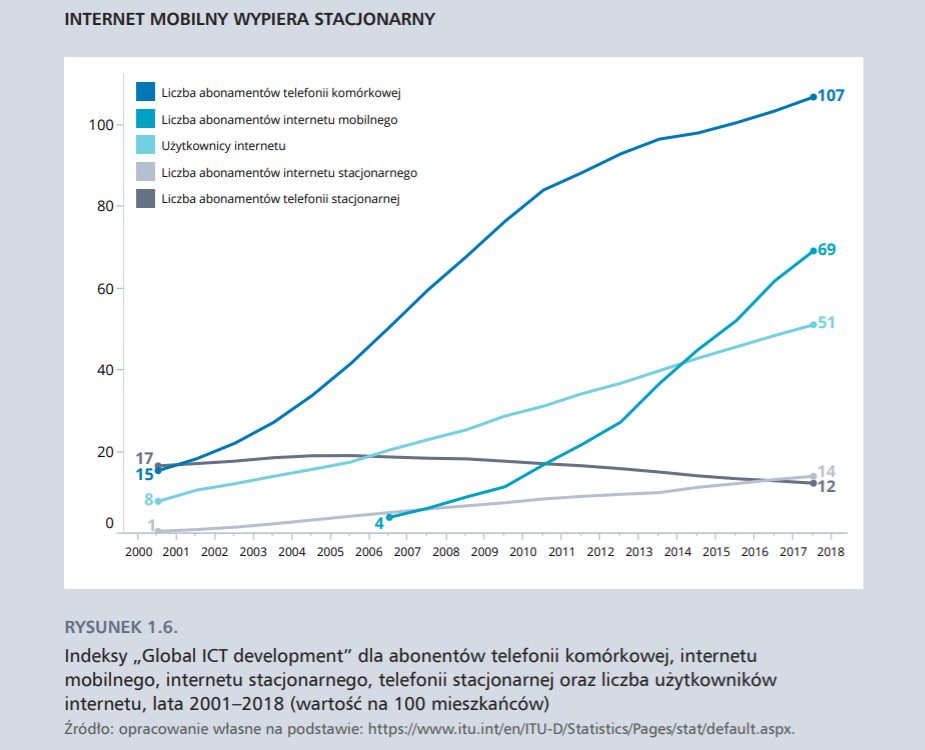

Kolejne komórki były coraz mniejsze, a lepsze baterie czyniły z nich sprzęt realnie mobilny. Miały też coraz więcej funkcji: można było z nich dzwonić, zapisywać kontakty czy prowadzić kalendarz. Do masowego upowszechnienia telefonów komórkowych przyczynił się również rozwój standardów łączności GSM. Pierwsza generacja – z której korzystała „cegła” Motoroli – była oparta na analogowych standardach telekomunikacyjnych, co wiązało się z niską jakością przesyłanego sygnału. W 1991 r. wprowadzono standard 2G, który opierał się na całkowicie cyfrowym, zaszyfrowanym sygnale, umożliwiającym wysyłanie krótkich wiadomości tekstowych (SMS-ów) i pakietu danych o prędkości do 50 kb/s. Sygnał cyfrowy poprawił jakość połączeń, zapewnił lepszy zasięg na większym obszarze i zmniejszył użycie baterii. Przełożyło się to na wzrost popytu na telefony komórkowe i ich szybki rozwój technologiczny. Wprowadzona w 1998 r. sieć 3G umożliwiła przesył danych i dostęp do sieci o prędkości 14 Mb/s, a następnie 28 Mb/s. Od 2009 r. dostępna jest sieć komórkowa 4G, umożliwiająca transfer danych dziesięciokrotnie szybszy w porównaniu ze standardem 3G, a często szybszy od tradycyjnych stacjonarnych łączy internetowych. Przesył danych i dźwięku oparty jest na standardzie LTE, stworzonym dzięki nowym technologiom przetwarzania i przesyłania sygnałów cyfrowych. A w tej chwili do użytku wchodzą technologie mobilne piątej generacji – 5G.

Smartfon

W pierwszej dekadzie XXI w. postępująca internetyzacja zyskała nowy nośnik w postaci kolejnej generacji mikrokomputerów – smartfonów. Przykładem pierwszych tego typu urządzeń był Simon wprowadzony do sprzedaży przez firmę IBM w 1994 r., samej nazwy zaś po raz pierwszy użyto przy sprzedaży lekkiego i wielofunkcyjnego Ericssona R380 działającego na systemie operacyjnym Symbian. Jednak prawdziwie wywrotowy charakter miał dopiero iPhone zaprezentowany w 2007 r. przez szefa Apple’a, Steve’a Jobsa, jako połączenie trzech urządzeń iPoda z szerokim dotykowym ekranem, rewolucyjnego telefonu komórkowego i przełomowego komunikatora internetowego. iPhone był przykładem sprytnej miniaturyzacji polegającej na łączeniu funkcji (combining functionality), które dotychczas były realizowane rozłącznie, zazwyczaj przez oddzielne urządzenia. iPhone mieścił w sobie gry, aparat fotograficzny i kamerę, ale tym akurat mogły się pochwalić i zwykłe Nokie. Jego przewaga konkurencyjna tkwiła w dotykowym ekranie i dotykowej klawiaturze, zintegrowanej przeglądarce internetowej i wytrzymałej baterii (Simon firmy IBM zniknął z rynku po kilku miesiącach, bo jego bateria działała po naładowaniu tylko godzinę). Przede wszystkim smartfon łączył w sobie funkcję mobilnego telefonu i komputera wystarczająco operatywnego, by zaspokoić potrzeby korzystania z internetu przez przeciętnego użytkownika. Produkt Apple, jako przenośny komputer, który nieustannie może być podłączony do internetu, poszerzył możliwości konsumpcji indywidualnej: konsumowane są treści cyfrowe oraz produkty kupowane za pośrednictwem e-handlu. Z perspektywy użytkowników indywidualnych smartfon spełnia rozliczne funkcje, bez których coraz trudniej jest się im obyć. W sondażu przeprowadzonym w 2017 r. 71% amerykańskich nastolatków w wieku 13–17 lat uznało, że nie byliby w stanie przeżyć tygodnia bez swojego smartfonu, ponad połowa tej grupy twierdzi, że nie przeżyłaby nawet dnia. Syndrom uzależnienia od telefonu zyskał już nawet nazwę: nomofobia.

Funkcjonalność i wszechstronność smartfony zawdzięczają oprogramowaniu: obecnie 86% tych urządzeń działa na systemie Android, bazującym na otwartym oprogramowaniu Linux. Wokół Androida powstało otwarte środowisko innowacyjne. Zewnętrzni innowatorzy uzyskują dostęp do systemu i danych generowanych przez użytkowników indywidualnych w zamian za tworzenie aplikacji, które zwiększają funkcjonalność głównego wynalazku. Symbioza zachodząca między systemem operacyjnym a twórcami aplikacji oraz użytkownikami jest przykładem funkcjonowania modelu platformowego. Użytkownik indywidualny niemal bezustannie generuje dane. Podłączone do sieci urządzenia mobilne są wyposażone w wiele aplikacji, które umożliwiają lokalizację, określają schematy przemieszczania się, śledzą nawyki oraz identyfikują preferencje. Twórcy oprogramowania tworzą kolejne rozwiązania ułatwiające codzienne życie, jak chociażby aplikacje do zarządzania wydatkami czy pozwalające zbierać informacje dotyczące aktywności fizycznej. Narzędzia z jednej strony mogą bazować na danych już wygenerowanych przez użytkowników, z drugiej zaś prowadzą do powstawania kolejnych informacji. System operacyjny – jako pośrednik między użytkownikami indywidualnymi a twórcami aplikacji – musi dążyć do przyciągnięcia jak największej liczby przedstawicieli obu tych grup.

Rozwój rynku smartfonów, ich nowe funkcjonalności i mnogość aplikacji przekładają się na czas, jaki poświęcamy na korzystanie z nich. W rezultacie zapotrzebowanie urządzeń na energię przekracza technologiczne możliwości baterii. Ciągła potrzeba ładowania smartfonów ogranicza wygodę ich używania, nielubianą koniecznością stało się noszenie powerbanków, czyli kompaktowych uzupełniających akumulatorów. W laboratoriach na całym świecie pracuje się nad nowymi technologiami, materiałami i właściwościami chemicznymi, które pozwolą stworzyć nowy typ baterii do urządzeń elektronicznych. W marcu 2017 r. 94-letni wynalazca ogniw litowo-jonowych, John Goodenough, ogłosił, że wraz z zespołem badaczy z University of Texas udało mu się zbudować szklaną baterię – trzy razy bardziej wydajną i ładującą się w kilka minut. Jego wynalazek wstępnie potwierdził renomowany Institute of Electrical and Electronic Engineers.

Ewolucja, którą przeszedł telefon komórkowy: od urządzenia umożliwiającego wykonanie mobilnego połączenia telefonicznego, przez urządzenie pozwalające na komunikację za pośrednictwem tekstów, do kieszonkowego komputera, który jest narzędziem do korzystania z setek aplikacji i funkcjonalności dotychczas dostępnych na innych urządzeniach, jest znakomitą ilustracją procesu innowacji kombinatoryjnej. Jednak transformacja cyfrowa w pełnym tego terminu znaczeniu byłaby niemożliwa bez opracowania wzajemnie warunkujących się technologii służących zbieraniu, przesyłaniu i analizie danych.

To kolejny odcinek publikowanej w naszym portalu książki Katarzyny Śledziewskiej i Renaty Włoch pt. „Gospodarka cyfrowa. Jak nowe technologie zmieniają świat”, wydanej przez DELab Uniwersytetu Warszawskiego.

Wkrótce, kontynuując wątek technologii, jakie umożliwiły start i rozwój przemysłu 4.0, opublikujemy w Platformie Przemysłu Przyszłości artykuł, w którym autorki, po powyższym omówieniu technologii założycielskich, szczegółowo opiszą technologie intensyfikujące. Wśród tych rozwiązań znajdą się chmura obliczeniowa, sztuczna inteligencja, blockchain, internet rzeczy i robotyzacja.

Wcześniej badaczki analizowały w serwisie PPP m.in. awans danych do strategicznej roli w gospodarce czy trudności w pomiarze gospodarki 4.0.