Zmiana klimatu i degradacja środowiska stanowią zagrożenie dla Europy i reszty świata. Aby sprostać tym wyzwaniom, Europa potrzebuje nowej strategii na rzecz wzrostu służącej przekształceniu Unii w nowoczesną, zasobooszczędną i konkurencyjną gospodarkę, która w 2050 roku osiągnie zerowy poziom emisji gazów cieplarnianych netto i w której nastąpi oddzielenie wzrostu gospodarczego od zużywania zasobów – czytamy na stronie poświęconej Europejskiemu Zielonemu Ładowi. Osiągnięcie założeń EZŁ ułatwi zmniejszanie zapotrzebowania przedsiębiorstw na energię oraz surowce. Przykłady optymalizacji kosztów prowadzenia działalności można ująć w 3 grupach. Są to: produkcja, warunki lokalowe oraz cyfryzacja.

Niższe koszty produkcji

Każdy przedsiębiorca stara się redukować koszty wytworzenia pojedynczego egzemplarza produktu. Jest to zadanie bez końca – niekiedy w setkach można liczyć procesy, którym trzeba poddać dany surowiec dla uzyskania efektu końcowego. Optymalizacja jednego kroku wymusza zmiany w kolejnym, który zajmuje miejsce najbardziej kosztownego działania. Poprzez zastosowanie centrów obróbczych i zintegrowanych układów wykonujących wiele zadań bez potrzeby przezbrajania, oszczędza się zarówno czas, pieniądze jak i surowce niezbędne do wykonania danego kroku produkcyjnego.

Początkowo obróbką skrawaniem zajmowały się m.in. tokarki, które raz ustawione mogły wytwarzać identyczne elementy przez wiele dni. Wdrożenie systemów szybkiego montażu narzędzi i obrabianych części zwiększyło wydajność całego procesu, a także umożliwiło przeprowadzanie wielu operacji na jednym elemencie i znacząco zmniejszyło czas przezbrajania i zmiany parametrów obróbczych. Kolejnym krokiem było wprowadzenie cyfrowych centrów obróbczych, także wieloosiowych, w których raz wpisany program pozwala wykonywać dziesiątki procesów na danym elemencie automatycznie wymieniając narzędzia, kontrolując proces skrawania i wielokrotnie zwiększając wydajność produkcji. Zaprogramowanie zdigitalizowanego centrum zajmuje więcej czasu niż narysowanie prostego elementu na kartce i zaznaczenie wymiarów ołówkiem, jednak dzięki nowoczesnym aplikacjom projektowym modyfikacja istniejącego kodu i wprowadzanie drobnych korekt do urządzenia sterowanego numerycznie pozwala w zaledwie kilka godzin uruchomić proces produkcyjny bardzo skomplikowanego elementu. Nie jest to możliwe przy zastosowaniu klasycznych, analogowych metod i zasad rysunku technicznego.

Wprowadzenie niewielkich zmian w procesie produkcji, jak np. zastosowanie środków smarnych różniących się dodatkami zmniejszającymi tarcie, może pozytywnie wpłynąć na żywotność stosowanych narzędzi i urządzeń. Jest to istotne, ponieważ koszt wytworzenia narzędzia do prasy lub wytłaczarki potrafi pochłonąć wiele pieniędzy i energii. Dodatkowo, dostępne oprogramowanie komputerowe pozwala ulepszyć procesy produkcyjne, np. optymalizować rozkład elementów na arkuszu blachy, z którego będą wytłaczane lub wycinane laserowo (bądź plazmowo) płaskie kształtki stanowiące półprodukt do wytworzenia elementu końcowego. Dzięki oprogramowaniu wykorzystującemu obliczenia metodą elementów skończonych MES (ang. finite element method, FEM), da się przeprowadzić optymalizację kształtów elementów obciążonych mechanicznie, która przy zachowaniu odpowiedniego współczynnika bezpieczeństwa, pomoże wybrać odpowiednią ilość materiału niezbędną do zachowania pożądanych właściwości wytrzymałościowych.

Gospodarka obiegu zamkniętego nie musi koniecznie oznaczać wykorzystywania wszystkich odpadów produkcyjnych w tym samym zakładzie pracy. Nie powinniśmy oczekiwać od firmy zajmującej się np. wytwarzaniem bram ogrodzeniowych, wyposażenia swojego zakładu w piec do wytopu stali, gdzie ze ścinków i resztek materiałowych wytworzy nowe kształtowniki i profile. Podobnie, drukarnia nie musi być wyposażona w młyny, sita, prasy i całe zaplecze chemiczne. Bardzo popularne jest odsprzedawanie resztek poprodukcyjnych przedsiębiorstwom, od których kupiło się wcześniej surowiec. Huty chętnie przyjmują złom, wytwórcy papieru makulaturę, zaś producenci opakowań skupują tworzywo z recyklingu. Oczywiście, należy w tym miejscu zaznaczyć, że skuteczność odzysku surowców wtórnych w Polsce, według danych z 2020 roku, nie przekracza 35%, co plasuje nasz kraj daleko poza podium Europy – jesteśmy na 18 miejscu na 26 badanych państw.

Warunki lokalowe przedsiębiorstw

Kolejnym aspektem mającym wpływ na zużycie energii w przedsiębiorstwach są warunki lokalowe. O ile w ciągu ostatnich 20 lat wysoka izolacja budynków stała się standardem, o tyle mało efektywne systemy ogrzewania, energochłonne źródła światła i brak kultury dbania o niskie straty energetyczne nadal są problemem wielu przedsiębiorstw. Standardowe kaloryfery do poprawnej pracy potrzebują temperatury czynnika grzejnego w zakresie 45-60°C, przez co wymagają zastosowania znacznie wyższych nakładów energetycznych niż systemy ogrzewania podłogowego lub ściennego, w których temperatura cieczy nie powinna przekraczać 30-35°C. Zapotrzebowanie na energię cieplną budynku znacznie zmniejsza zastosowanie systemów odzysku ciepła, tzw. rekuperatorów. Z kolei wydajna wentylacja mechanicznej z odzyskiem ciepła zredukuje konieczność otwierania okien, a tym samym – zużycie energii. Warto przeanalizować zastosowanie energooszczędnych źródeł światła LED, których technologia w ostatnich latach poprawiła zarówno żywotność diod jak i odwzorowywanie przez nie barw.

Dobra izolacja budynku, nowoczesne systemy grzewcze i źródła światła nie przyniosą efektu, gdy w przedsiębiorstwie brakuje odpowiedniej kultury pracy – otwarte na oścież drzwi czy zostawienie na noc włączonego oświetlenia na hali produkcyjnej skutecznie zniweczą inwestycje przedsiębiorcy. Oprócz rozmów z pracownikami i prowadzenia szkoleń, dobrą praktyką jest stosowanie automatycznych regulatorów temperatury, często programowalnych – dzięki nim można dopasować temperaturę pomieszczenia zależnie od pory dnia. Proste samozamykacze drzwi czy czujniki ruchu uruchamiające oświetlenie tylko wtedy, gdy ktoś jest w pomieszczeniu, również będą „cichym pomocnikiem” ułatwiającym oszczędzanie energii.

Od wielu firmowych serwerów do chmury

Według raportów rynkowych sprzedaż nowych komputerów do firm znacznie spada, co jest spowodowane tylko nieznacznym wzrostem wydajności procesorów i innych newralgicznych podzespołów z generacji na generację. Dla większości pracowników, którzy korzystali głównie z pakietów biurowych i prostych aplikacji niewymagających potężnych stacji roboczych, różnice wydajności były niezauważalne. Oczywiście, aplikacje wykorzystujące każdy takt procesora w 100% działały wydajniej, jednak różnice nie powodowały diametralnej zmiany w przepływie pracy.

Prawdziwa optymalizacja nastąpiła jednak w wydajności na wat – jeszcze w 2005 roku nikt nie słyszał o laptopach, które na jednym ładowaniu działają 18-20 godzin. Mimo że pracownik nie odczuwa różnicy w szybkości działania aplikacji pomiędzy obecnym procesorem a odpowiednikiem sprzed 5 lat, to licznik energii elektrycznej kręci się o wiele wolniej. Znaczną poprawę wydajności i responsywności systemów komputerowych uzyskuje się poprzez zastosowanie szybkich dysków Solid State Drive. Dyski SSD, oprócz nawet kilkudziesięciokrotnie większej szybkości odczytu i zapisu danych w stosunku do klasycznych dysków talerzowych, cechują się również mniejszą awaryjnością i odpornością na uderzenia, ze względu na brak ruchomych elementów oraz znacznie niższym zapotrzebowaniem na energię. Kilka watów w jednym komputerze nie brzmi jak wielka różnica, jednak gdy w firmie używa się ich kilkaset, wpływ na rachunki za energię zaczyna być widoczny.

Same rozwiązania z zakresu ICT również bardzo mocno ewoluowały. 20 lat temu serwerownie w przedsiębiorstwach miały wiele urządzeń wyspecjalizowanych – jeden serwer obsługiwał pocztę firmową, na innym stała strona WWW, na kolejnym przechowywano bazę danych, z której korzystali pracownicy itp. Każdy z tych serwerów był osobnym urządzeniem, z własną płytą główną, procesorem, pamięcią, dyskami twardymi i zasilaczem. Duże zapotrzebowanie na urządzenia wyeliminowała wirtualizacja. Dzięki tworzeniu maszyn wirtualnych wszystkie sprzęty można zastąpić jednym mocnym urządzeniem z wirtualnymi systemami operacyjnymi. Oczywiście, taka maszyna musi być odpowiednio mocniejsza, jednak dzięki zastosowaniu jednej płyty głównej, jednego wydajnego procesora, pojemniejszych dysków twardych i jednego zasilacza, znacząco zmniejszyło się zapotrzebowanie na prąd i miejsce w szafie serwerowej (w tekście celowo pomijam systemy wieloprocesorowe, zasilanie redundantne i inne rozwiązania z data center, dla uproszczenia omawianych zagadnień).

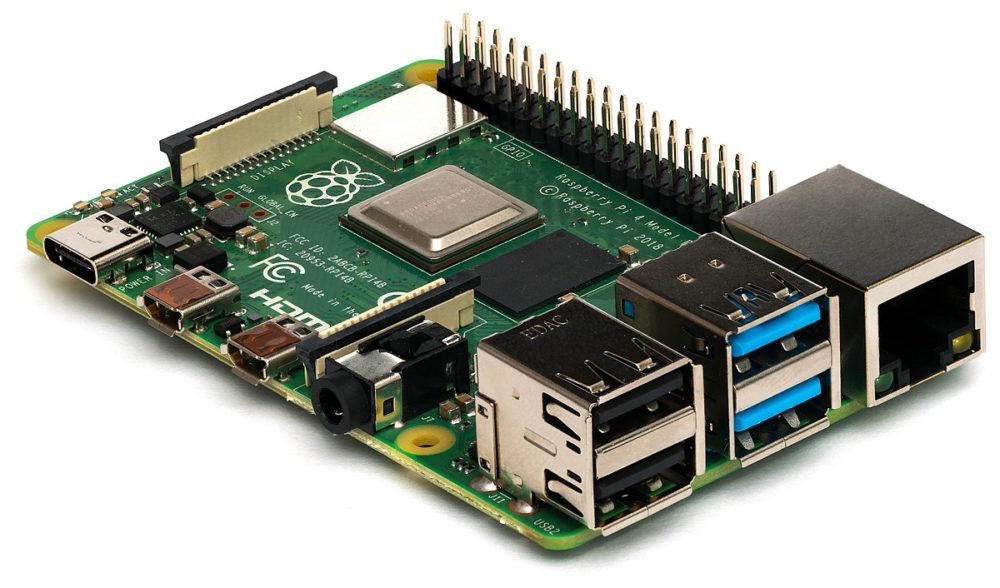

Odgórnie przydzielone zasoby dla każdej z maszyn wirtualnych oraz ewolucja systemów w kierunku dynamicznego przypisywania mocy obliczeniowych poszczególnym zadaniom, znacząco zmniejszyły niewykorzystane cykle procesora i jednocześnie zwiększył wydajność całej platformy. Kolejnym krokiem była dalsza optymalizacja – zastosowanie bazowego systemu operacyjnego z kontenerami spełniającymi pojedyncze zadania – przykładem może być popularne oprogramowanie Docker, które pozwala na dalsze obniżanie strat mocy obliczeniowej okrawając dany kontener do niezbędnego minimum koniecznego do działania aplikacji. Umożliwiło to również kolejną bardzo istotną zmianę paradygmatu – skalowalność. Dzięki zastosowaniu dużej ilości tanich i wyspecjalizowanych mini-komputerów (Raspberry Pi, Mac Mini z procesorem M1 itp.) o bardzo wysokiej wydajności na wat i okrojonych z niepotrzebnych rozwiązań sprzętowych, można było, dzięki odpowiedniemu oprogramowaniu, tworzyć klastry, a także szybko i tanio (nowe Raspberry Pi to koszt rzędu 35$) zwiększać wydajność całego systemu informatycznego w firmie.

Dla przedsiębiorców, którzy nie chcą prowadzić własnej serwerowni powstały rozwiązania chmurowe – Microsoft Azure, Amazon Web Services czy Google Cloud Platform, eliminujące drogie urządzenia, infrastrukturę, a także kadrę zarządzającą serwerami na rzecz abonamentu pozwalającego na używanie urządzeń dostawców usług cloud computingu. Przedsiębiorca nie musi się martwić wygospodarowaniem miejsca na serwerownię, odpowiedniego zasilania głównego i awaryjnego, zapewnienia dostępu jedynie określonym grupom osób, utrzymaniem i naprawami samych urządzeń. Wszystkie te aspekty wziął na siebie dostawca chmury. Dodatkowo, dzięki wyspecjalizowanej infrastrukturze data center, koszt energetyczny i wpływ na środowisko jednego serwera jest znacznie niższy niż w przypadku użytkowania tego samego serwera przez przedsiębiorcę na terenie własnego obiektu.