Trudności związane z projektowaniem systemów opartych o AI przedstawił Miłosz Kaszyński z firmy OKE Poland. Jego zdaniem, głównym problemem, z jakim borykają się inżynierowie, jest dokładność:

– Sieci neuronowe zazwyczaj działają na zasadzie prawdopodobieństwa, więc precyzyjność nigdy nie jest stuprocentowa – wyjaśniał.

Kolejną rzeczą jest stabilność – choć algorytmy działają zadowalająco w laboratoriach, ich dokładność przy wdrożeniu produkcyjnym może się zmniejszyć. Sztucznej inteligencji brakuje również rzetelności, bo nawet przy dokładności 98% pozostałe 2% ma szansę spowodować duże straty. Specjalista opowiedział o projektach, które prowadzi jego firma – o systemie Civileo automatycznie analizującym dźwięk i obraz czy warunki środowiskowe w miastach, a także o aplikacji Vileo przeznaczonej dla mieszkańców do kontaktu z sąsiadami.

Powstaną godne zaufania systemy AI?

Sebastian Cygert z Politechniki Gdańskiej zastanawiał się nad możliwością wykorzystania algorytmów w systemach istotnych dla bezpieczeństwa, m.in. w medycynie, pojazdach autonomicznych i robotyce. Podkreślił, że AI godna zaufania powinna dobrze dostosowywać się do nowych warunków i odpowiednio szacować niepewność:

– Chodzi o to, żeby w sytuacji, kiedy algorytmy nie umieją zwrócić poprawnej odpowiedzi, były w stanie przekazać, że nie potrafią rozpoznać obrazu, zamiast podawać błędną informację z wrażeniem dużej pewności. Sztuczna inteligencja godna zaufania powinna tłumaczyć, dlaczego podjęła taką, a nie inną decyzję, i być sprawiedliwa, czyli nie opierać sądów na płci czy kolorze skóry – argumentował Cygert.

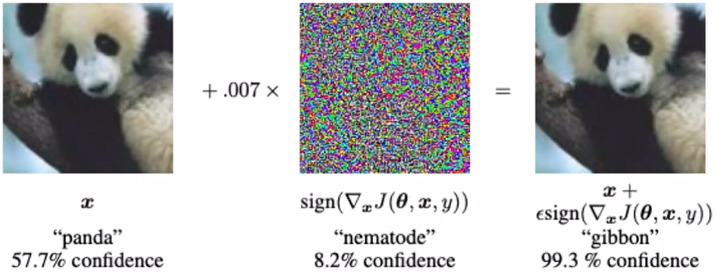

Naukowiec dowodził, że jeszcze nie dysponujemy idealnymi sieciami neuronowymi. W czasie wystąpienia pokazał szereg sposobów na zmylenie algorytmów, związanych z niewielkimi (niedostrzegalnymi dla ludzkiego oka) manipulacjami obrazem czy zmianą warunków pogodowych. W jednym przypadku wystarczył deszcz, żeby SI nie zauważyła pieszych na drodze.

Dobre i złe algorytmy

Sztuczna inteligencja z jednej strony zastępuje ludzi w niebezpiecznych i powtarzalnych zajęciach oraz wspiera m.in. osoby starsze w codziennych czynnościach. Pomimo zalet, według Magdaleny Popowskiej z Politechniki Gdańskiej, coraz szersze stosowanie AI każe zastanawiać się nad konsekwencjami dla rynku pracy, demokracji czy zależności ludzi od algorytmów. Naukowiec opowiedziała o inicjatywach, które zajmują się etycznymi aspektami AI, np. o grupie eksperckiej Komisji Europejskiej High-Level Expert Group on Artificial Intelligence oraz o pracach Instytutu Inżynierów Elektryków i Elektroników (IEEE) nad przygotowaniem pierwszego certyfikatu przyznawanego sprawiedliwym algorytmom.

Zatoka Sztucznej Inteligencji

Wydarzenie zorganizował klub Politechniki Gdańskiej AI Bay – Zatoka Sztucznej Inteligencji we współpracy z Hubem Innowacji Cyfrowych DIH4AI. Profesor Jacek Rumiński, prezes AI Bay, zapowiedział kolejne działania klubu, m.in. zdalne szkolenia i międzynarodową konferencję Human-System Interaction 2021. Przybliżył także plany otwarcia na Politechnice Gdańskiej AI Living Lab, czyli laboratorium umożliwiającego testowanie i usprawnianie aplikacji bazujących na sztucznej inteligencji. Z AI Living Lab i opisywanego już przez nas laboratorium robotycznego w Gdańskim Parku Naukowo-Technologicznym będą mogli skorzystać przedsiębiorcy współpracujący z DIH4AI.