Monitorowanie czegokolwiek, a w szczególności sieci, większości osób kojarzy się ze zbieraniem danych, generowaniem wykresów itd. Tymczasem, jeśli chodzi o monitorowanie systemów informatycznych, służące do tego platformy najczęściej mają na celu powiadamianie odpowiednich osób, gdy pojawiają się anomalia. W konsekwencji administrator może znacznie szybciej zareagować, niejednokrotnie usuwając problem jeszcze zanim zauważą go pracownicy.

Jednakże monitorowanie sieci nie kończy się na sprawdzaniu statusu usług i hardware’u. Analizowanie dzienników i poprawnych uwierzytelnień pozwala administratorom na szybkie dostrzeżenie np. potencjalnych cyberataków lub wycieków haseł. Dzięki alertom wysyłanym przez platformy administrator może podjąć działania prewencyjne, choćby blokując dostęp do serwera z danego adresu IP lub konto, którego hasło trafiło w ręce hakera. Niemniej taki tryb jest reaktywny – następuje post-factum – i nie zapobiega właściwie atakom czy wyciekom danych. Dobrą techniką będzie tzw. monitorowanie proaktywne.

Tradycyjnie słabe ogniwo…

Specjaliści IT mają wachlarz rozwiązań, które na co dzień dbają o bezpieczeństwo firmowych danych. Są to platformy antymalware’owe, zaawansowane metody uwierzytelniania, systemy zarządzania urządzeniami mobilnymi, zapory i wiele innych rozwiązań – każde odpowiedzialne za specyficzny zakres ochrony bezpieczeństwa. Jeśli wziąć pod uwagę różnorodność systemów, ich liczbę oraz funkcjonalność, można uznać, że sieci firmowe powinny być odporne na wszelkiego typu ataki. Programy antywirusowe zabezpieczają przed każdego rodzaju marlware’m (w tym ransomware’m), systemy Mobile Device Management dbają o bezpieczeństwo urządzeń mobilnych, systemy antyspamowe odfiltrowują niebezpieczne wiadomości, automatyczne aktualizacje utrzymują oprogramowanie w najnowszej i najbezpieczniejszej wersji, zapory blokują ataki z zewnątrz, a podwójne uwierzytelnienie zapobiega włamaniom związanym z wyciekiem haseł. Teoretycznie wszystko działa i możemy spać spokojnie.

Tymczasem 2019 był kolejnym rokiem rekordów w dziedzinie incydentów cybernetycznych, nawet dla wielkich instytucji. Bank CapitalOne ucierpiał w jednym z największych dotychczasowych ataków, w wyniku którego skradziono dane osobowe około 100 milionów Amerykanów. Facebook przyznał się do wycieku 540 milionów rekordów, a miasto Baltimore straciło ponad 18,2 miliona dolarów z powodu ataku ransomware. Można dojść do wniosku, że systemy zabezpieczające zawiodły, nawet wielkich graczy.

Jednak za większością problemów z cyberbezpieczeństwem stoją nie systemy a człowiek – sama technologia rzadko nas zawodzi. Według badania Canona, przeprowadzonego w ubiegłym roku na ponad tysiącu amerykańskich specjalistów IT, dwa główne źródła zagrożenia bezpieczeństwa sieci to osoby o złych intencjach, mające dostęp do informacji poufnych (30%) oraz błąd człowieka (25%). Zewnętrzne ataki, czyli złamanie lub obejście oprogramowania wskazało tylko 17% respondentów.

Badanie Canona nie zdradza jednak niczego, czego już byśmy nie wiedzieli. Specjaliści IT od lat alarmują, że najsłabszym ogniwem w dziedzinie cyberbezpieczeństwa jest człowiek. W opublikowanym w 2014 roku raporcie IBM stwierdzono, że ponad 95% wszystkich incydentów dotyczących naruszeń cyberbezpieczeńswa jest konsekwencją m.in. ludzkiego błędu (jako czynnika wspomagającego). Warto zatem zastanowić się, jak najczęściej dochodzi do wycieków lub incydentów w tej kategorii.

Inside attackers

Data Breach Investigation Report amerykańskiego giganta telekomunikacji Verizon zwraca uwagę na 5 typów tzw. inside attackers:

- Nieostrożny pracownik, który celowo łamie lub obchodzi zasady dopuszczalnego użytkowania systemów teleinformatycznych, np. przez instalowanie nieautoryzowanych aplikacji, wyłączanie oprogramowania zabezpieczającego albo łamanie ustalonych procedur. Działania te często nie są złośliwe, lecz podyktowane brakiem wiedzy lub chęcią uproszczenia pracy.

- Agent wewnętrzny to osoba mająca dostęp do informacji poufnych, zrekrutowana lub przekupiona z zewnątrz w celu przekazywania danych.

- Niezadowolony pracownik ma dostęp do poufnych informacji i usiłuje zaszkodzić swojej organizacji, niszcząc dane albo zakłócając działalność. Mogą to być np. ludzie, którzy odchodzą z zespołu lub czują się pokrzywdzeni przez pracodawcę.

- Złośliwy informator – pracownik z dostępem do danych korporacyjnych, który wykorzystuje nadane mu w systemie uprawnienia dla osobistego zysku. Może być motywowany przez hakerów prowizją od okupu przy okazji ataku ransomware albo zainteresowany sprzedażą własności intelektualnej.

- Beztroska trzecia strona to partner biznesowy, kontrahent narażający firmę na wyciek danych poprzez zaniedbanie lub niewłaściwe użycie danych. Ta kategoria obejmuje również podmioty trzecie, które niewłaściwie zarządzają informacjami, ewentualnie celowo powodują wyciek.

Gdy mamy do czynienia z agentem wewnętrznym, oprogramowanie zabezpieczające niewiele pomoże. Człowiek w swojej naturze ma wiele cech, które tworzą z niego idealną ofiarę ataku cybernetycznego. Robimy błędy, ulegamy presji czasu, zapominamy, możemy być motywowani emocjonalnie lub finansowo. Agentem wewnętrznym lub nieostrożnym pracownikiem może być każdy, kto wpadnie w socjotechniczną pułapkę.

Nawet jeżeli teoretycznie wyeliminujemy problemy związane z „czynnikiem ludzkim” w swoim przedsiębiorstwie, część danych jest przetwarzana przez partnerów biznesowych, kontrahentów i dostawców usług. Tutaj większość firm nie ma mechanizmów kontroli i adekwatnych procedur dla ryzyk związanych z beztroską trzecią stroną. Według badania KPMG „Clarity on Cyber Security” przeprowadzonego w 60 szwajcarskich firmach, aż 44% respondentów stwierdziło, że nie dysponuje żadnymi instrumentami umożliwiającymi egzekwowanie ram kontroli kontrahentów i dostawców. Co więcej, 82% planów cyberobsługowych nie obejmowało procedur wokół incydentów, takich jak ataki hakerskie na partnerów biznesowych. Innymi słowy – duża część firm funkcjonuje wyłącznie z nadzieją, że ich dane nie wyciekną do internetu, zamiast proaktywnie zadbać o ich bezpieczeństwo.

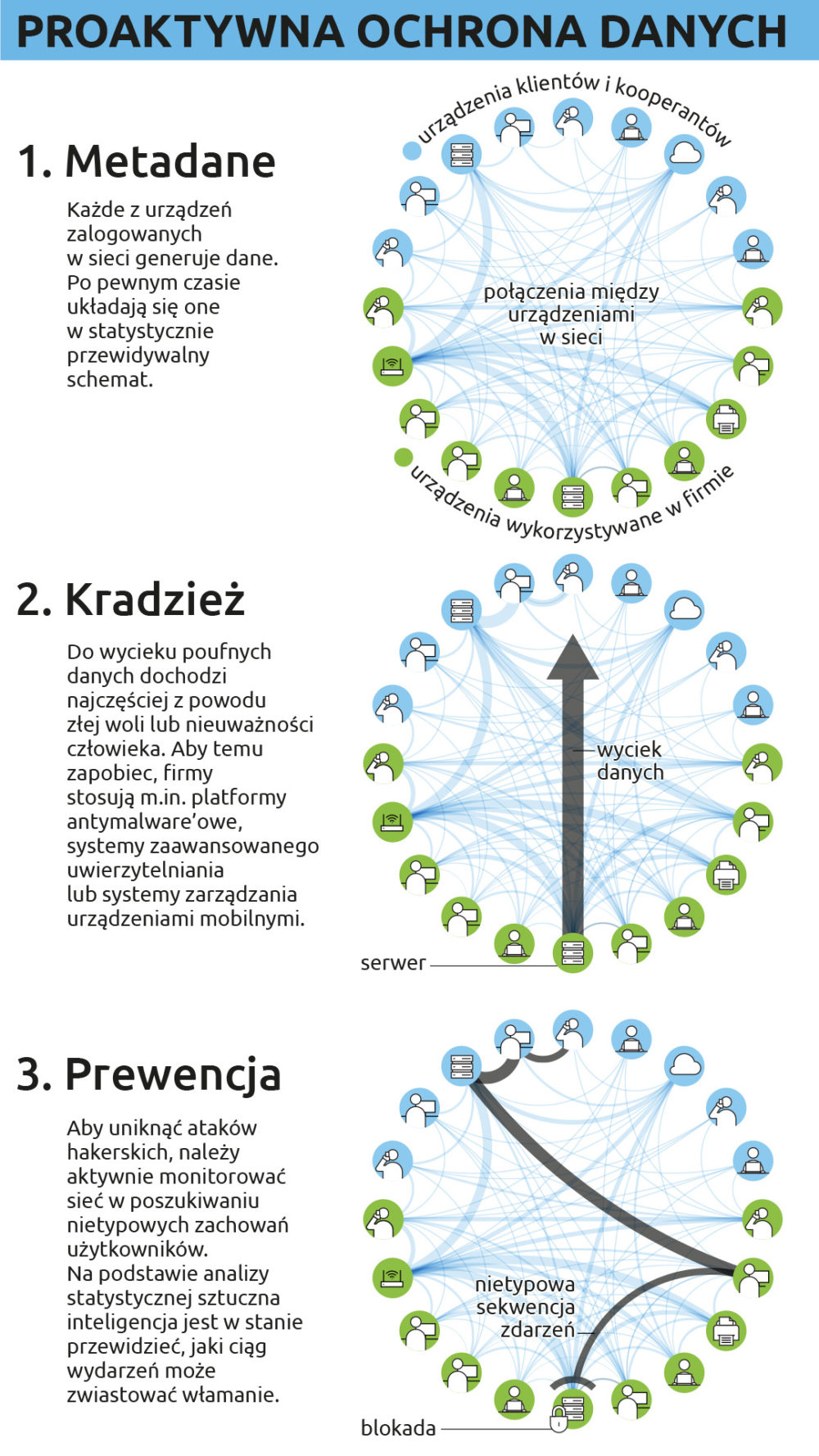

Logiczną odpowiedzią na zagrożenia płynące ze środka organizacji jest monitorowanie pracowników i kontrahentów. Jednak monitoring użytkowników łączy się z licznymi problemami budowania zaufania wewnątrz firmy. Pracownicy nie lubią być sprawdzani i mogą czuć się z tym niekomfortowo, ponadto dochodzą kwestie prywatności i etyki związane z zakresem i ilością zbieranych danych. Dla przykładu, istnieje możliwość odszyfrowania ruchu w sieci, choć jednocześnie pojawiają się pytania: czy użytkownik miał prawo do prywatności oraz czy mógł się spodziewać, że jego ruch był widoczny, mimo szyfrowania. Kontrahent natomiast może nie pozwolić na dogłębny dostęp do swojej infrastruktury, dając wyłącznie wgląd w metadane. W tej sytuacji, w przeciwieństwie do monitorowania reaktywnego, monitorowanie proaktywne oferuje wygodne rozwiązanie zarówno dla przedsiębiorstw, jak i użytkowników dbających o prywatność.

Monitorowanie proaktywne

To wyciąganie wniosków w oparciu o dotychczas zebrane dane oraz podejmowanie działań mających zapobiec negatywnym skutkom w najbliższej przyszłości. W świecie IT od pewnego czasu taki typ monitorowania był stosowany np. do określania liczby podzespołów czy szacowania daty ich wymiany. Najnowszym trendem jest używanie opisywanej metody również do analizy zachowań użytkowników. Do niedawna monitorowanie ogromnej ilości metadanych było zadaniem, któremu większość działów IT nie umiała sprostać.

Po pierwsze, różnorodność systemów zabezpieczających jest tak duża, że interpretacja danych z wielu punktów naraz bywa bardzo czasochłonna lub wręcz niemożliwa. Systemy antyspamowe, skanery malware’u, platformy MDM i każde inne rozwiązanie ma własne dzienniki i terminologię. Aby zrozumieć logi tworzone przez oprogramowanie, trzeba zapoznać się z formatem, składnią oraz kodami błędów.

Po drugie, nie każde rozwiązanie dzieli się ze sobą danymi, przez co dostrzeżenie korelacji jest utrudnione. Systemy zabezpieczające informacje dość często pracują jak samotne wyspy i nie mają możliwości dzielenia się danymi. Jeśli jednak związek istnieje, zwykle wymaga dodatkowej opłaty za integrację, ale nie każde przedsiębiorstwo może sobie na to pozwolić.

Po trzecie, monitorowanie metadanych i logów jest pracą zbyt czasochłonną, żeby mogła być ekonomicznie uzasadnionym obowiązkiem specjalistów IT. Zależnie od konfiguracji i liczby zdarzeń w sieci, oprogramowanie potrafi generować gigabajty danych tylko w ciągu jednej doby. Zapoznanie się z ich treścią oraz zwrócenie uwagi na błędy ma miejsce dopiero wtedy, gdy problem jest na tyle krytyczny, że zauważają go użytkownicy. Poza podobnymi wyjątkami, większość administratorów nie czyta (i nie ma czasu na czytanie) zawartości logów.

Wkracza AI

Tymczasem sztuczna inteligencja staje na wysokości zadania, bo:

- w przeciwieństwie do ograniczonego czasu, jakim dysponują pracownicy działów IT, AI pracuje 24/7 i ma prawie nieograniczoną, skalowalną siłę obliczeniową;

- dzięki możliwości uczenia się jest w stanie zauważyć korelacje i efekty domina pomiędzy wydarzeniami w sieci, które mogą nie zostać wykryte przez odrębne, niekomunikujące się ze sobą systemy;

- za pomocą machine learningu sztuczna inteligencja jest w stanie nauczyć się, jakie zachowania w ruchu sieciowym sygnalizują istnienie Agenta wewnętrznego, bez ingerowania w prywatność użytkowników lub odszyfrowywania treści danych;

- przez wczesne wykrywanie niebezpiecznych zachowań AI może autonomicznie podjąć działania prewencyjne mające na celu wyodrębnienie użytkownika lub ograniczenie dostępu do poufnych danych w trybie natychmiastowym;

- wykorzystując dane statystyczne, ma szansę wytypować pracowników potrzebujących ponownego szkolenia z dziedziny cyberbezpieczeństwa lub wybrać użytkowników, których zachowanie wymaga intensywniejszego monitorowania.

Wnioski?

Niezależnie od wielości rozwiązań w zakresie bezpieczeństwa sieci jedynym sposobem na maksymalizację wydajności systemów jest wyeliminowanie problemów związanych z działaniami ludzi. To one od lat są najsłabszym ogniwem, jeżeli chodzi o odporność korporacji na ataki cybernetyczne. Do niedawna proaktywne monitorowanie zachowań użytkowników było niemożliwe bez głębokiej ingerencji w prywatność, co mogło powodować problemy dla relacji w firmie oraz otwierać furtkę do precedensów prawnych.

Dzięki oprogramowaniu do monitorowania sieci wyposażonemu w sztuczną inteligencję firmy zyskują możliwość integracji systemów, które do tej pory działały osobno, nie dzieląc się danymi. Połączenie zdarzeń z różnych systemów pozwala na wczesne wykrywanie zachowań i anomalii w oparciu o korelacje między metadanymi, jakie do tej pory mogły być niezauważane. Ponadto w przeciwieństwie do śledzenia użytkownika, używania keyloggerów i innych pokrewnych praktyk, AI nie musi ingerować w prywatność użytkowników, aby zauważyć potencjalnie niebezpieczne zachowania, co sprawi, że jej zastosowanie jest idealnym kompromisem pomiędzy potrzebami biznesu a ochroną prywatności pracowników.